Les interfaces graphiques du web sémantique

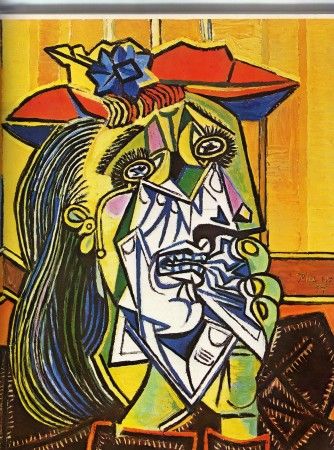

Bien souvent, quand je vois les interfaces graphiques des applications du web sémantique, cela me fait penser à du Picasso.

Paradoxe : quand les données sont structurées les interfaces graphiques donnent mécaniquement une impression de dé-structuration.

Si le document word est le modèle de document qui a inspiré la page du web de document, alors on pourrait peut-être penser que c’est le tableur qui représente le modèle de document du web de données ? On pourrait certainement le croire quand on regarde le très justement nommé Tabulator de Berners Lee, outil pour « surfer sur du RDF » :

Et bien non, c’est la carte et la localisation qui « prennent ». Ainsi, lorsque Tim Berners Lee a présenté les résultats des démarches d’ouverture des données publiques à TED 2010, il n’a présenté que des interfaces basées sur la géolocalisation des données :

Retour aux fondamentaux finalement, puisqu’on se souvient que les APIs et les mashups du Web 2.0 ont commencé avec Google Maps. Ce qui tend à montrer que la mise à disposition de données structurées sur le web s’inscrit dans une logique de re-territorialisaiton : rien n’est plus démonstratif que de projeter les données sur une carte.

Imaginez par exemple que vous soyez une bibliothèque et que vous vouliez publiez vos données en RDF : que pouvez-vous espérer qu’il en ressorte ? Et quelles interfaces pourront être proposées, par des tiers, quand les données seront disponibles ? Avoir les données agrégées autour d’une oeuvre ou d’un auteur est bien utile mais l’on retombe sur un web documentaire classique même si le moteur est en RDF.

Alors on repense à cette histoire de re-territorialisation, et on imagine immédiatement des services de localisation des ouvrages dans les bibliothèques. On revient encore à la carte en projetant sur elle les données, même si, en l’occurrence, c’est typiquement un réflexe d’institution que de vouloir in fine « router » et ramener le public dans ses murs.

Si nous devions formuler correctement la question, il faudrait dire : « Quels sont les informations territoriales que je possède ? ». Et dans notre cas : « quelles informations territoriales possède une bibliothèque ? », si l’on retient l’idée qu’il y a corrélation entre l’ouverture des données structurées et une logique de re-territorialisation.

J’ai parlé du territoire, c’est à dire de l’espace, mais c’est aussi vrai du temps, ici le projet Simile avait déjà tracé la voie. Ce sont les informations avec une métadonnée temporelle ou spatiale dont le « marché » a besoin en priorité.

Ex sur Bibliosurf

– Géolocalisation de documents http://www.bibliosurf.com/spip.php?page=jeu_de_cartes&test=240

– Datation de documents

http://www.bibliosurf.com/spip.php?page=time

– Agrégation de flux : indexation et nuage de mots clés

http://www.bibliosurf.com/spip.php?page=nuage_auteurs_les_plus_commentes

Bon surf.

[Reply]

Je confirme que la carte (au sens large de la représentation graphique d’informations dans un espace) est un paradigme très efficace pour appréhender un espace structuré. Nous l’utilisons pour chacun de nos projets et nous obtenons des résultats très intéressants et surtout efficaces. Je me permets de vous « pointer » deux billets sur le sujet :

– http://blog.onomia.com/2010/04/21/de-la-cartographie-geographique-a-la-cartographie-semantique

– http://blog.onomia.com/2010/05/12/pourquoi-utiliser-des-cartes-point-de-vue-scientifique

Si le sujet vous intéresse, n’hésitez pas à nous contacter on adore échanger sur ces thèmes !

[Reply]

c »est en fait un retour à la théorie des loci ???

[Reply]