L’Un et le Multiple comme défi technologique du Cloud Computing

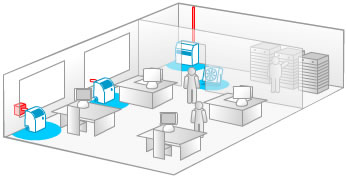

Construire un data center est tout ce qu’il y a de plus simple : un local, de l’électricité, des ordinateurs et une connexion réseau suffisent.

Construire un data center est tout ce qu’il y a de plus simple : un local, de l’électricité, des ordinateurs et une connexion réseau suffisent.

Toutes les entreprises et les institutions d’une certaine taille ont un data center, plus prosaïquement une salle des machines, aussi modeste soit-elle. Mais les data centers dont je veux parler sont des data centers qui sont passés à une échelle industrielle : il n’y a qu’a penser au million de serveurs de Google. Toute cette infrastructure n’est plus là pour supporter les applications de telle ou telle organisation, ni pour répondre aux besoins d’un nombre restreint et limité de personnes, mais pour répondre aux centaines de millions de sollicitations par jour effectuées via le web.

Pour qualifier ces nouveaux data centers qui délivrent des services via le web, un nouveau terme semble s’imposer, on parle de Cloud Computing. Pourquoi « cloud » (nuage) ? Parce que, historiquement, dans les schémas d’architecture des réseaux informatiques, internet était représenté comme un nuage, une sorte de no man’s land, à la fois porte d’entrée et de sortie du réseau maîtrisé de l’entreprise. Le terme de nuage, cloud, est resté, et on parle donc aujourd’hui de cloud computing, de puissance de calcul sur le web, dans les nuages.

Des data centers de la superficie d’une grande surface commerciale, Google en possède plus de trente, et l’ensemble de ces data centers, localisés en différents endroits et sur plusieurs continents, doivent travailler de concert et en cohérence en eux. Il y a donc deux éléments qu’il faut prendre en compte dans la logique de cloud computing : d’une part de très grands data centers, mais également des data centers qui doivent inter-opérer dans une logique réticulaire.

Les grands acteurs industriels du web qui ont monté ces plates-formes web de cloud computing ont dû relever un véritable défi technologique. Ce défi technologique je l’appelle le défi de l’Un et du Multiple. C’est une question centrale de la tradition philosophique depuis les grecs que celle de l’un et du multiple, et c’est cette même question qui s’est rejouée récemment dans le champ technologique.

Pour illustrer ce point je prendrai deux exemples, celui de la parallélisation avec Google puis celui de la virtualisation avec Amazon :

- Chaque requête faite par un utilisateur sur le moteur de recherche de Google va atteindre, en moins de 0,25 secondes et quasi simultanément, entre 700 et 1000 machines dans les data centers de Google. Ce que fait technologiquement Google, c’est transformer une requête unique en une multiplicité de requêtes traitées parallèlement sur plusieurs machines, dans des grappes de serveurs, pour ensuite agréger l’ensemble des résultats de cette multiplicité de requêtes en une réponse qui sera celle qu’affiche la liste des résultats dans le navigateur web. Google se distingue donc dans les technologies de parallélisation qui est une façon de relever le défi de l’un et du multiple : à savoir comment passe-t-on de l’un au multiple et, inversement, du multiple à l’un.

Amazon s’est illustrée par un autre défi technologique, qui relève également de la question de l’un et du multiple, et du passage de l’un à l’autre. La question n’est plus comme avec Google d’éclater des requêtes qui vont être redistribuées puis agrégées, il s’agit ici dé-corréler la vision logique d’un data center de sa vision physique. Rappelons qu’Amazon est essentiellement un vendeur de livres et de produits culturels en ligne et, à ce titre, son activité a d’importantes variations saisonnières, avec un gros pic d’activité pour les fêtes de fin d’année. Pour faire face à cette recrudescence saisonnière d’activité, ce vendeur en ligne a du construire une infrastructure technologique qui se retrouve, en période creuse, avec un taux d’occupation très faible. Amazon a donc été confronté à une question classique que rencontre tout industriel qui doit d’optimiser le taux d’occupation de son infrastructure :

- Amazon a ainsi mis en place une virtualisation de son infrastructure informatique afin de vendre le surplus de puissance et de stockage dont elle disposait. La virtualisation est un procédé qui consiste à dé-corréler la vision physique de la vision logique des infrastructures de machines. On peut ainsi avoir une seule machine qui est considérée comme étant une multiplicité de machine. Bien que la technologie de virtualisation ne sont pas toutes récente, Amazon à relevé le défi non seulement de la mettre en place sur de très grandes quantités de machines mais, en plus, d’automatiser l’allocation de ces ressources logiques permettant ainsi à chacun de mettre en place un serveur virtuel, en ligne et sans intermédiaire.

Les acteurs historiques de l’industrie des telecom reprochent bien souvent aux acteurs du web de ne pas participer à l’infrastructure du web, voulant nous faire croire que ce sont des companies qui n’investissent pas et se contentent de toucher le jackpot. Ces propos sont récurrents lorsqu’on évoque le financement de nouveaux réseaux à très hauts débits. Or rien n’est plus faux, car ces nouveaux acteurs du web ont su relever de grands défis technologiques et sociétaux qui ont nécessité, en proportion de leur taille, d’énormes financements. Jamais les acteurs des telcos ne laisseront le web tranquille car ce sont fondamentalement des industries basées sur des rentes de situation, ce que n’est pas du tout le web.

Bien sûr, Google comme Amazon représentent également une menace potentielle permanente risquant de compromettre les promesses portées par la neutralité du net, mais ils font bouger les lignes et bousculent les rentiers de l’industrie.

Aussi ne faut-il pas dénigrer leur inventivité, leurs efforts et leurs succès : ce sont eux qui inventent et nous forcent à nous re-configurer et à nous ré-inventer.

Très bon papier,

pour aller dans ton sens, si ce que font ces géants était facile, rien n’empêche d’autres acteurs de le faire… et ils sont peu nombreux sur les rangs tant ces acteurs placent la barre haut.

Ils ont repensé les architectures en faisant le contraire de ce qui est préconisé (si on disait que pour executer un traitement on passait par 100 serveurs on passerait pour un fou au bureau…), le tout pour un cout très faible avec des serveurs very low cost (au départ ils ne s’embêtaient même pas avec des boitiers). Bref le contraire des archis classiques.

Oui google, amazon … ont en quelques années réinventé l’informatique.

comme Microsoft a pu créer un écosystème, google commence a créer le sien. Ces dizaines de start-up pensent de développent des applications sur apps engine, amazon … L’agilité que leur donne ces architectures leur donne un avantage certain sur les architectures classiques qui nécessitent de repenser le code, les serveurs, redimensionner… sans arrêts. Leurs couts seront lissés par rapport aux résultats que se soit a la hausse ou à la baisse.

Ces sociétés vont bousculer encore un peu plus le marché, elles seront capables d’évoluer vite, fournir de nouvelles versions aux clients sans qu’ils aient a la patcher, avoir une rente liée au service, pas besoin de faire du support sur 50 versions (la dernière est la seule version donc de réduire leurs couts), capables d’adresser rapidement des millions d’utilisateurs partout dans le monde, …

Nous n’avons encore rien vu !

Si Microsoft a créé un monde en standardisant le PC,ergonomique, pas trop cher, avec des outils de développements plutot bon, on voit bien que Google et autres vont essayer de faire la même chose.

Comme disait Ballmer, Microsoft n’est pas un requin dans l’océan, mais l’océan lui même. Est-ce que Lary et Sergei vont arriver au même résultat ?

[Reply]

A noter un papier exactement sur ce thème dans le monde diplomatique de ce mois-ci : « A l’ère de l’« informatique en nuages » »

http://www.monde-diplomatique.fr/2008/08/LE_CROSNIER/16174

Thomas

[Reply]

[…] «L’Un et le multiple comme technologique du Cloud Computing.» Christian Fauré «Des data centers de la superficie d’une grande surface commerciale, Google en possède plus de trente, et l’ensemble de ces data centers, localisés en différents endroits et sur plusieurs continents, doivent travailler de concert et en cohérence en eux.» […]

Top ! A quand la suite avec l’utility computing ? (ça sent la saga à la star wars 😉 )

[Reply]